ErgoLAB Interaction原型人機交互分析模塊,是津發科技依據人因工程和人-信息-物理系統(HCPS)理論自主研發的面向多模態數字化信息產品的 “以人為中心"的“人-信息系統交互"評估系統,具備被試庫管理與屬性篩選、問卷與量表調查、WEB/APP/VR等多類型信息產品或原型的設計與導入、AOI興趣區自動識別與自定義編輯、測試過程同步記錄、多模態數據同步采集分析、以及實驗數據嵌入式回放等功能,借助科學量化的統計數據,分析得出面向特定用戶的信息產品功能設計的有效性和可用性。適用于裝備研制和產品開發的全生命周期,能夠幫助在產品開發初期修正策劃方案、產品投產階段提供改進方案、產品銷售疲軟期找出問題癥結。

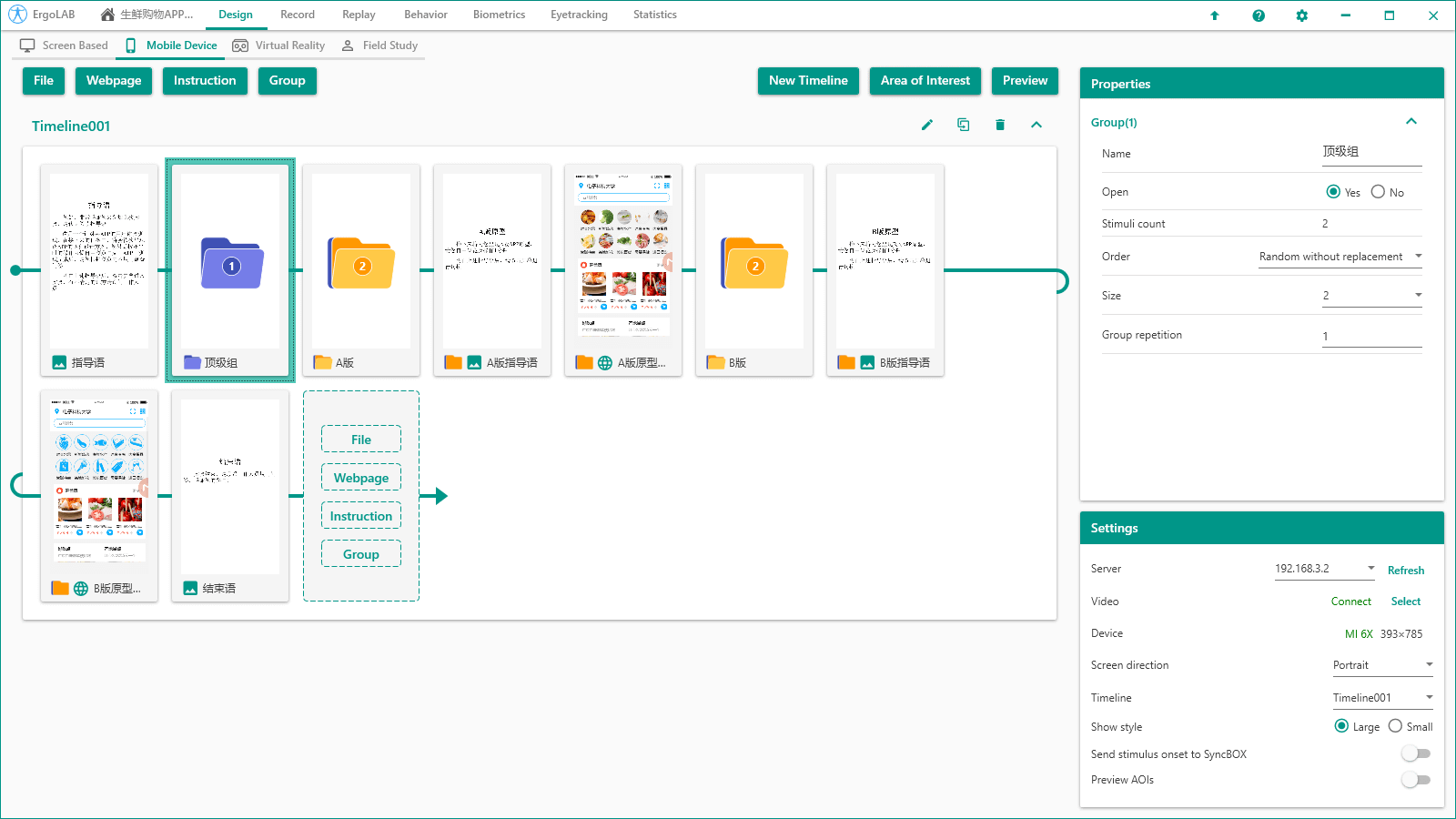

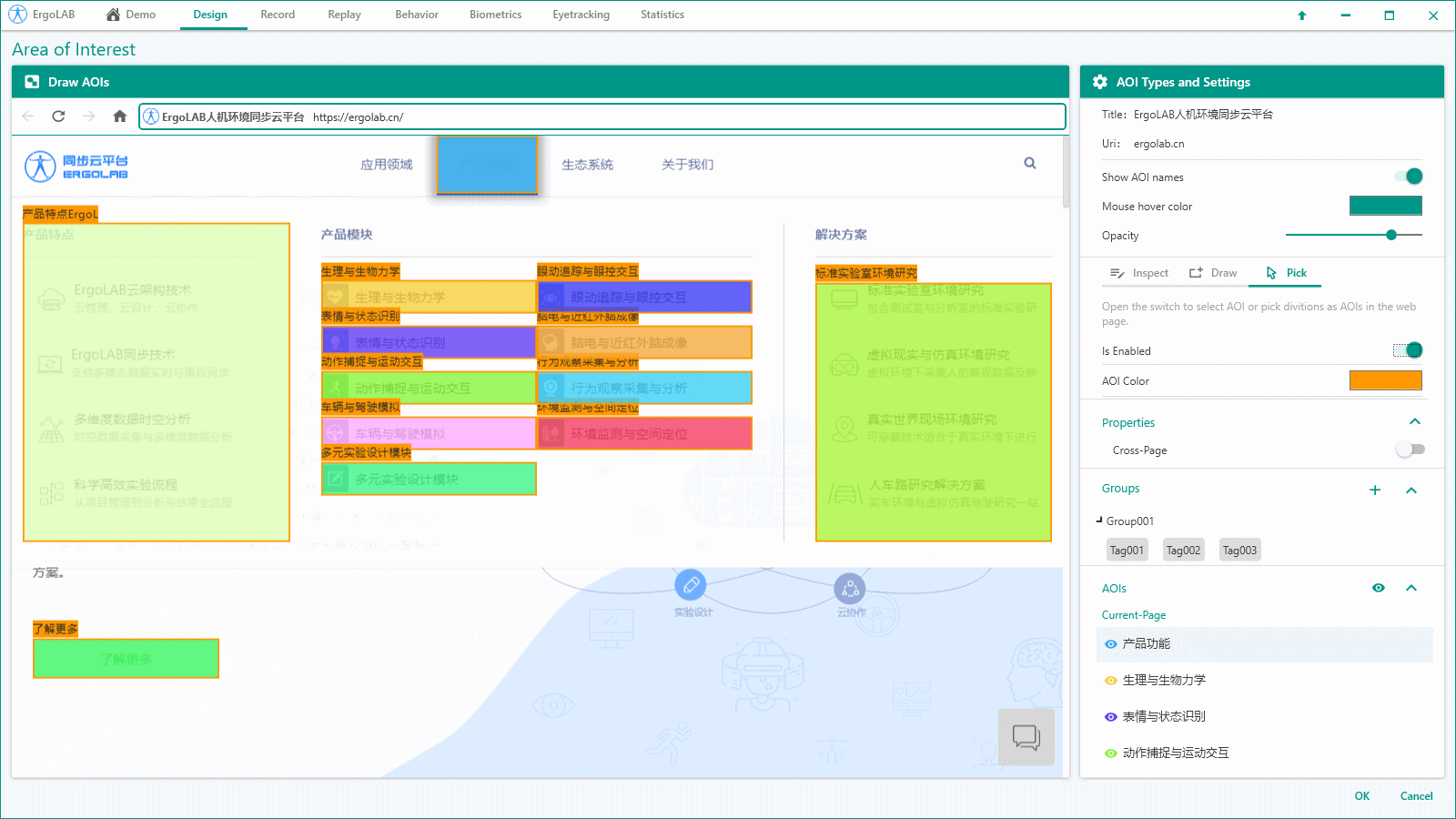

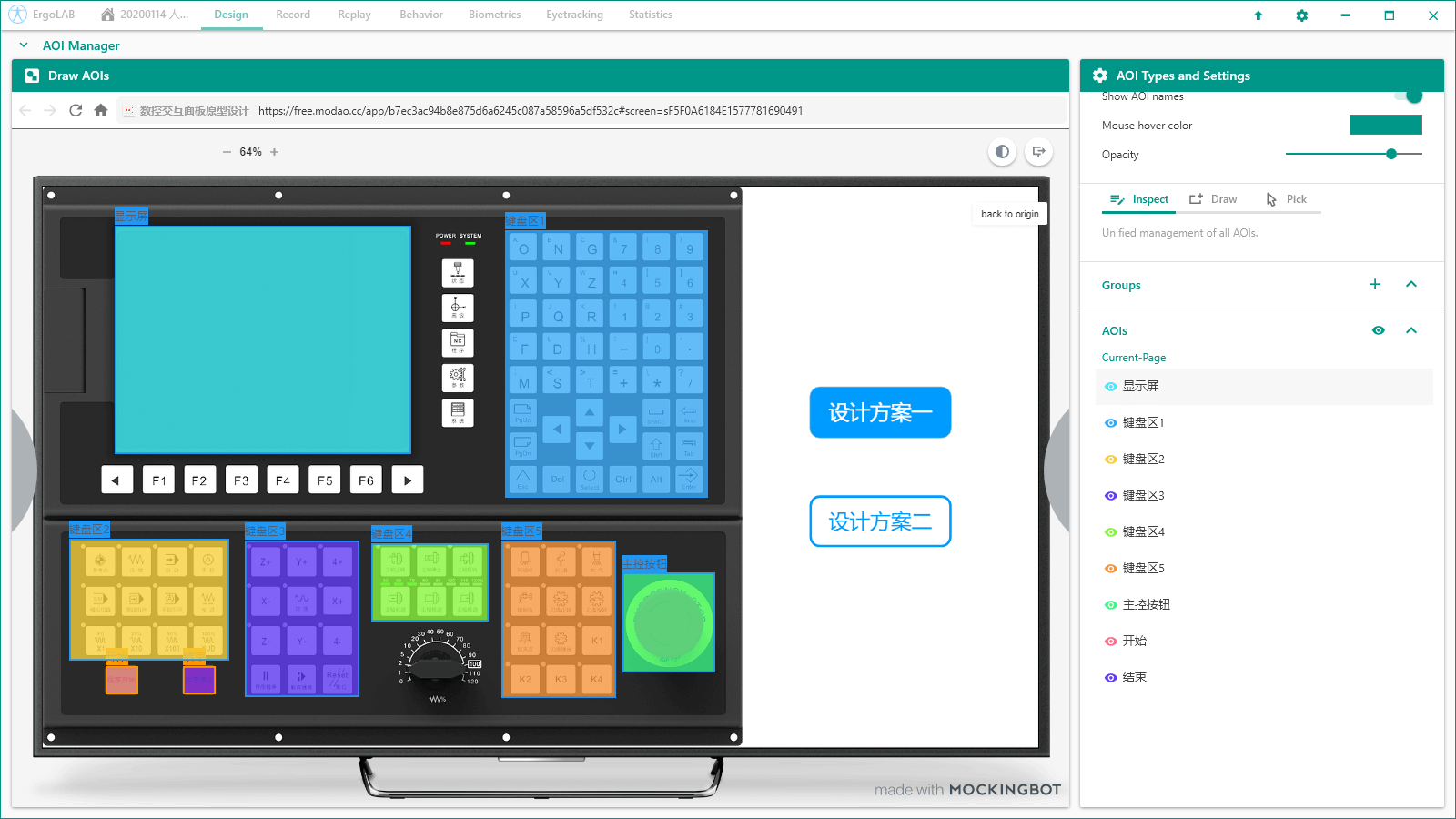

適用于多種產品交互分析:支持一鍵導入本地及云端的基于桌面端、移動終端、虛擬仿真等多類型載體產品;支持主流原型設計軟件內容一鍵導入;保留產品內容和交互的完整性。標準化可用性測試流程:提供從被試庫云管理、實驗設計、數據采集、存儲、分析到智能應用的科學完整測試流程,檢驗產品的交互性,確保準確高效進行測試。AOI興趣區自動識別與自定義編輯:自動識別原型頁面組件,支持便捷點擊設定興趣區;支持繪制自定義形狀和位置的興趣區。測試完畢即可查看報告。無線實時同步采集移動端原型數據:桌面端實驗設計可實時映射至移動端,以便被試在更自然的狀態下進行實驗;被試與移動端的交互數據亦可實時傳輸記錄至系統中。多通道數據同步采集:可連接眼動、生理、行為等多項硬件采集設備,支持多源數據同步采集。多被試數據同步采集與分析:采用云端技術,支持多被試數據同步采集;支持多被試數據一鍵處理與疊加分析。跨平臺實驗設計模塊

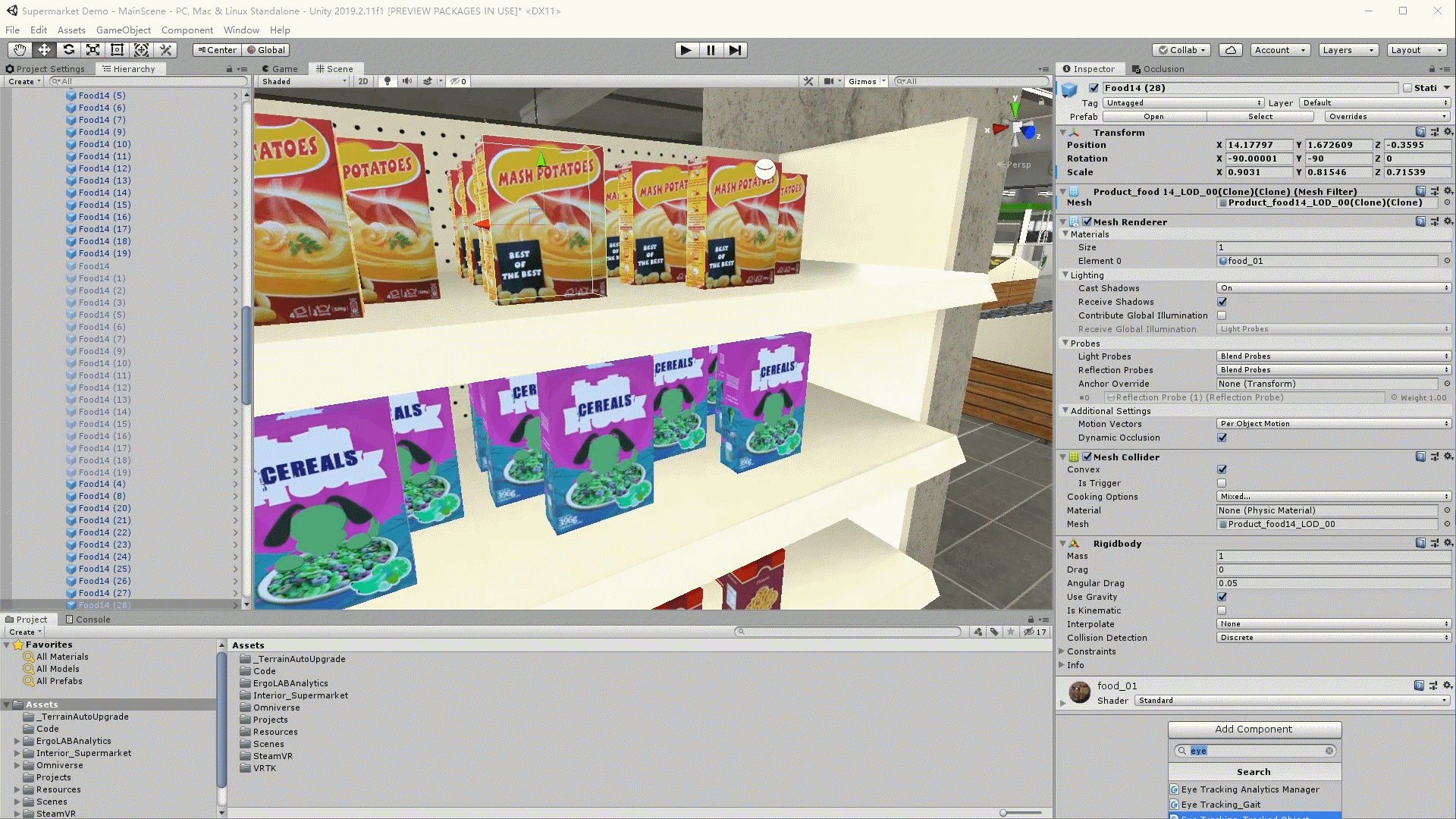

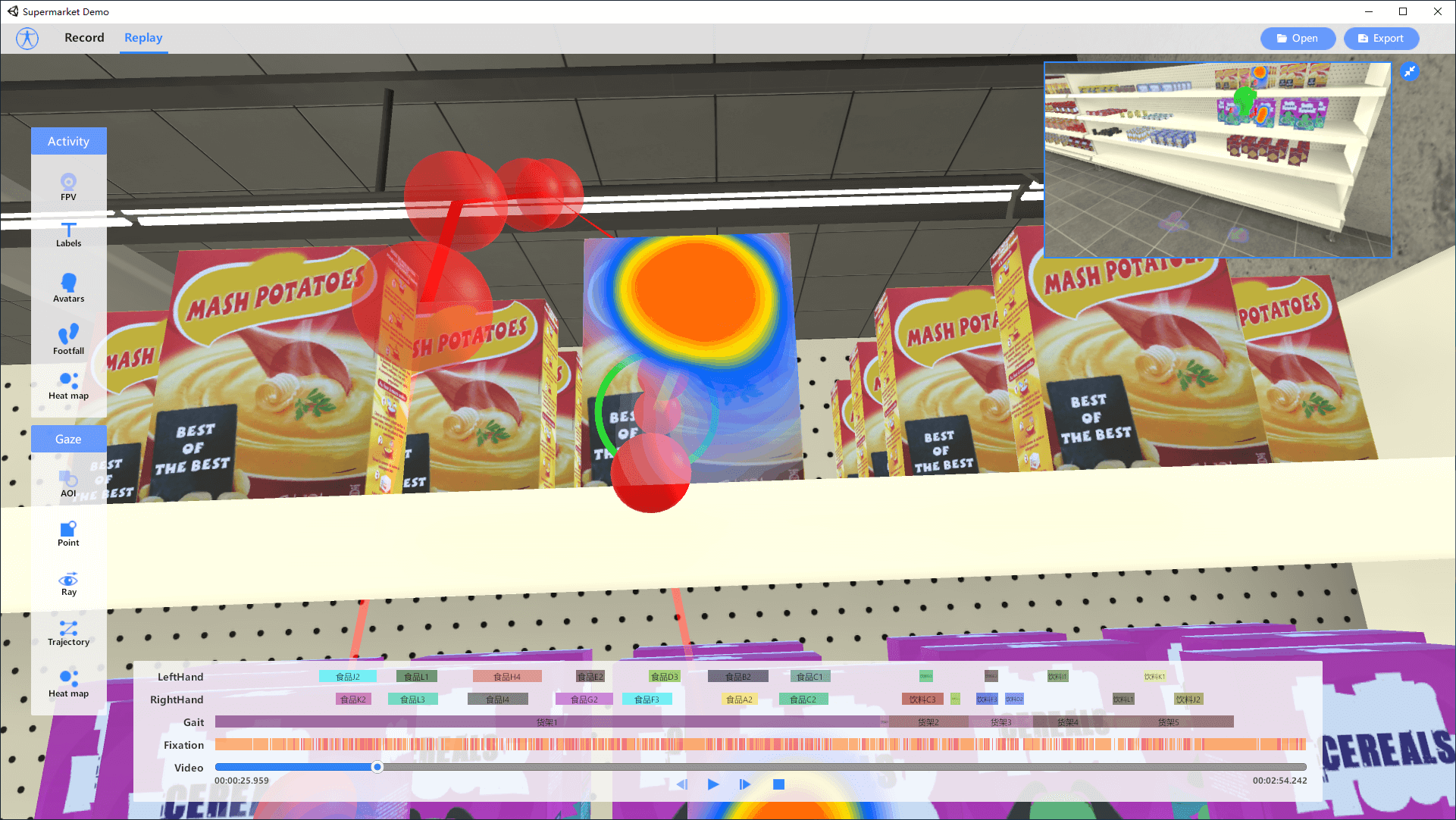

完備的PC終端實驗設計:支持刺激材料與屬性自定義,可在同一項目中設置一個或多個時間軸,原型、網頁程序、圖片、文字、視頻等多種刺激材料也可并存于同一時間軸。靈活的移動終端實驗設計:用戶可在電腦端與移動終端同步進行實驗設計,如設置刺激分組、呈現順序和切換方式等,系統可實時無線采集被試在移動端與原型交互的眼動數據和交互數據;開放式VR平臺實驗設計:刺激呈現類型支持自定義,可導入全景圖片、全景視頻,以及max、fbx、obj等任意格式的3D模型,使用嵌入式資源包ErgoVR PLUGIN可在刺激材料上直接興趣區及物體,記錄完整交互數據。支持可穿戴頭盔VR、沉浸式CAVE及多人交互設備開展實驗。自動高效完成實驗流程

興趣區智能識別與自定義繪制:系統自動計算并識別所有原型組件信息,點選即可將其為興趣區域;支持自定義繪制任何形狀和位置的興趣區。實驗設計階段與結果回放階段均可進行編輯,交互數據自動統計并輸出可視化報告。自適應界面顯示尺寸:基于任意類型的信息化終端載體進行產品與原型的可用性測試,對于同一產品應用于不同尺寸的顯示載體時,用戶只需繪制一次興趣區,系統將自動調節用于所有尺寸的顯示載體進行交互數據的計算與分析。完整保留原型交互信息:基于任意類型的信息化終端載體進行應用程序與原型的測試分析,系統可直接識別原型中的所有組件并以像素位置進行計算,實現在交互測試過程中的實驗設計階段、結果回放以及數據分析階段,均能保證刺激材料不失真,客觀還原所有交互設置及數據反應。交互數據可視化分析

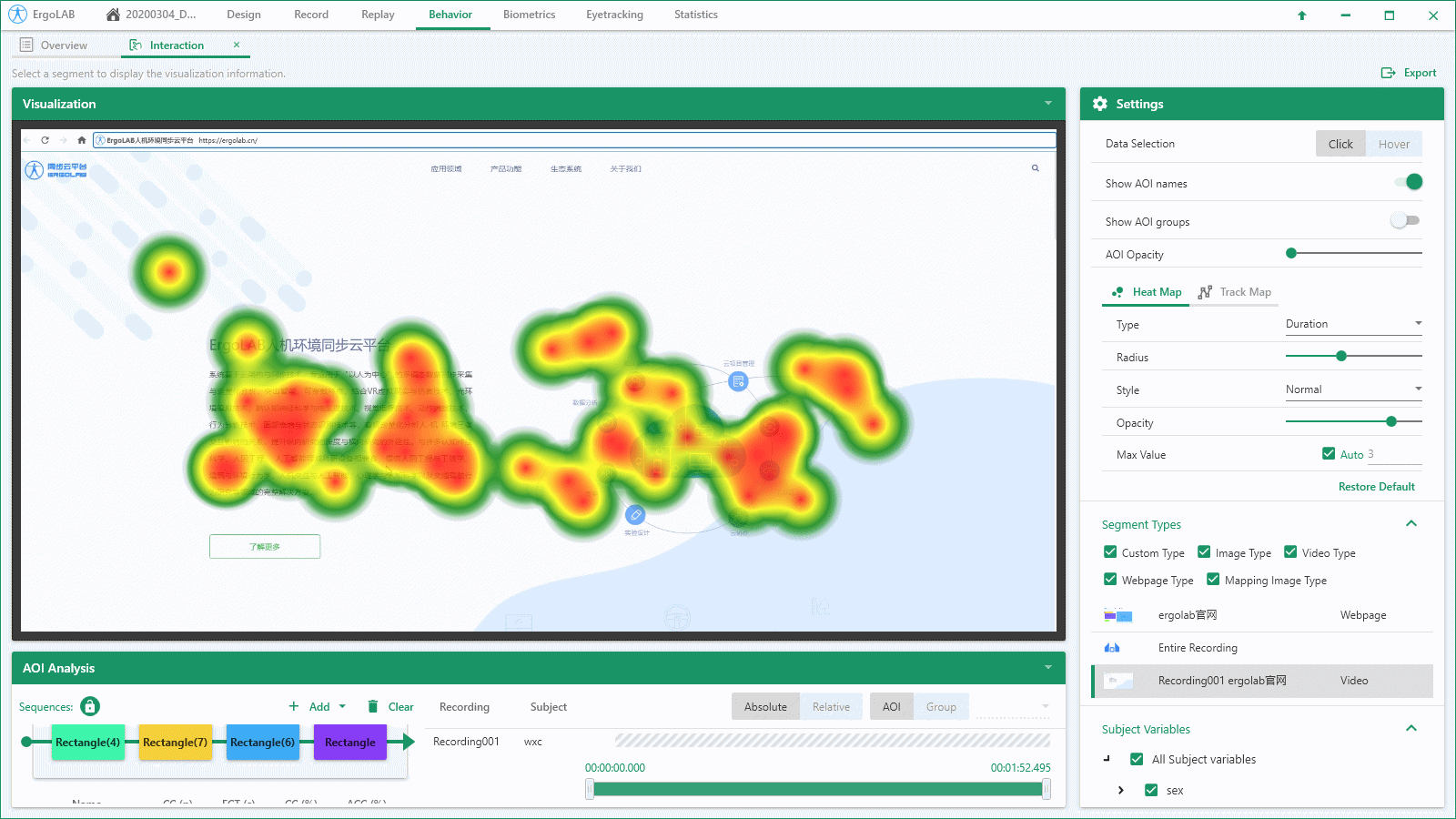

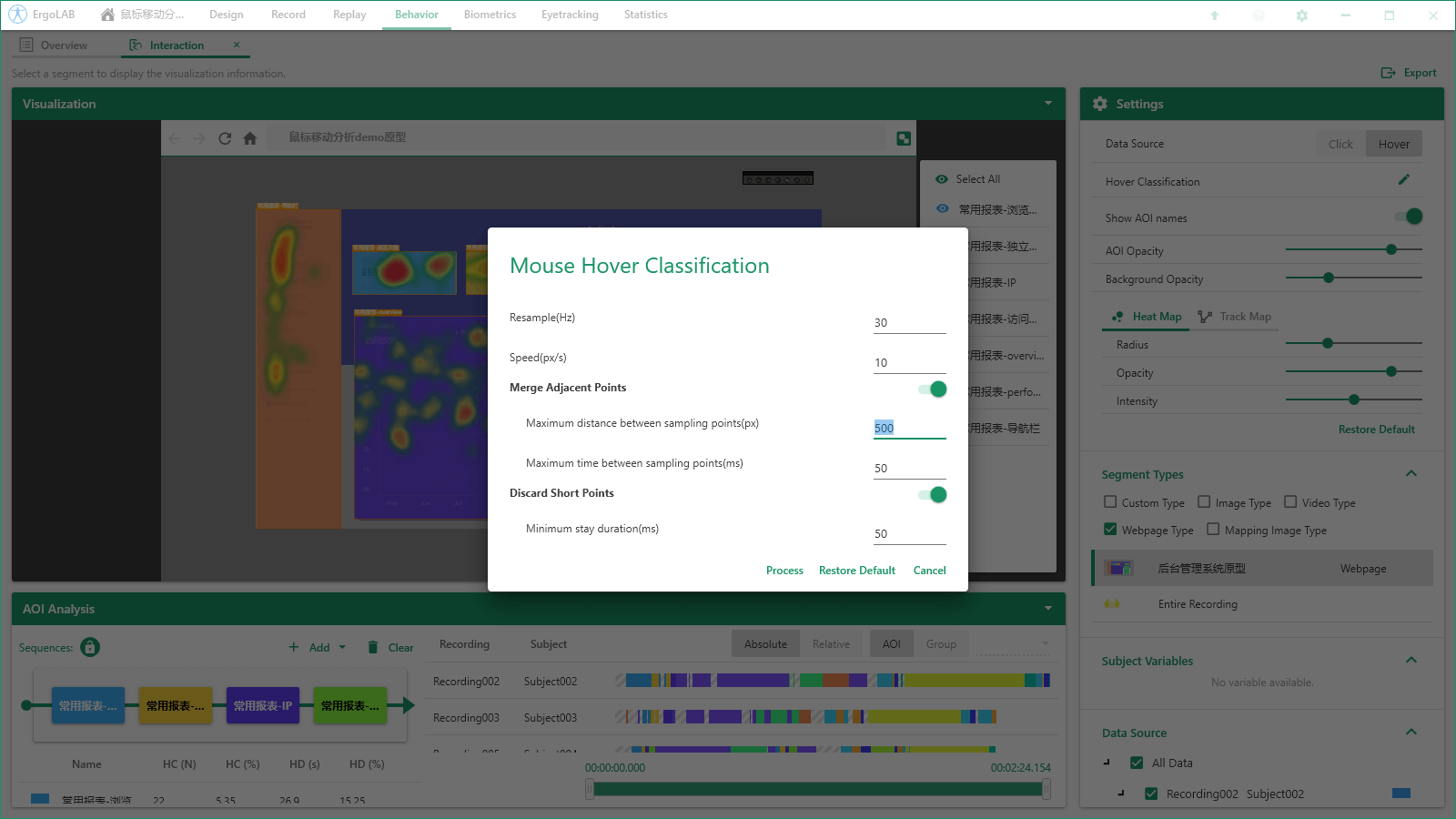

可視化熱圖:直觀分析用戶的重點交互區域,包括桌面端鼠標點擊、懸浮等交互,移動端手指點擊、滑動、縮放等交互,VR端行走軌跡、手柄交互等時間維度數據運用平面維度呈現,豐富的色彩有助于直觀展示用戶的真實需求與關注點,深入理解用戶期待和動機。可視化軌跡圖:準確記錄鼠標點擊軌跡、懸浮軌跡,以及VR三維空間中被試行走軌跡,反映視覺加工過程中注視的整體、序列和動態的變化狀況。序列性分析:提供相關興趣區連帶分析功能,可將多個目標興趣區自定義導入序列,包括對AOI的分析和對AOI組別的分析,可用于探究一個興趣區的內容是否促使被試查看另一個興趣區的序列性關系。鼠標移動/懸浮行為分析:系統自動統計鼠標懸浮時間、鼠標滑動速度、最小懸浮時間等,支持自定義劃分鼠標移動與懸浮行為。相似度分析:提供分析不同記錄相同片段間,被試訪問AOI順序的相似度,并計算矩陣相似度系統。有助于判斷記錄間操作的一致性與合規性。多維度數據綜合統計

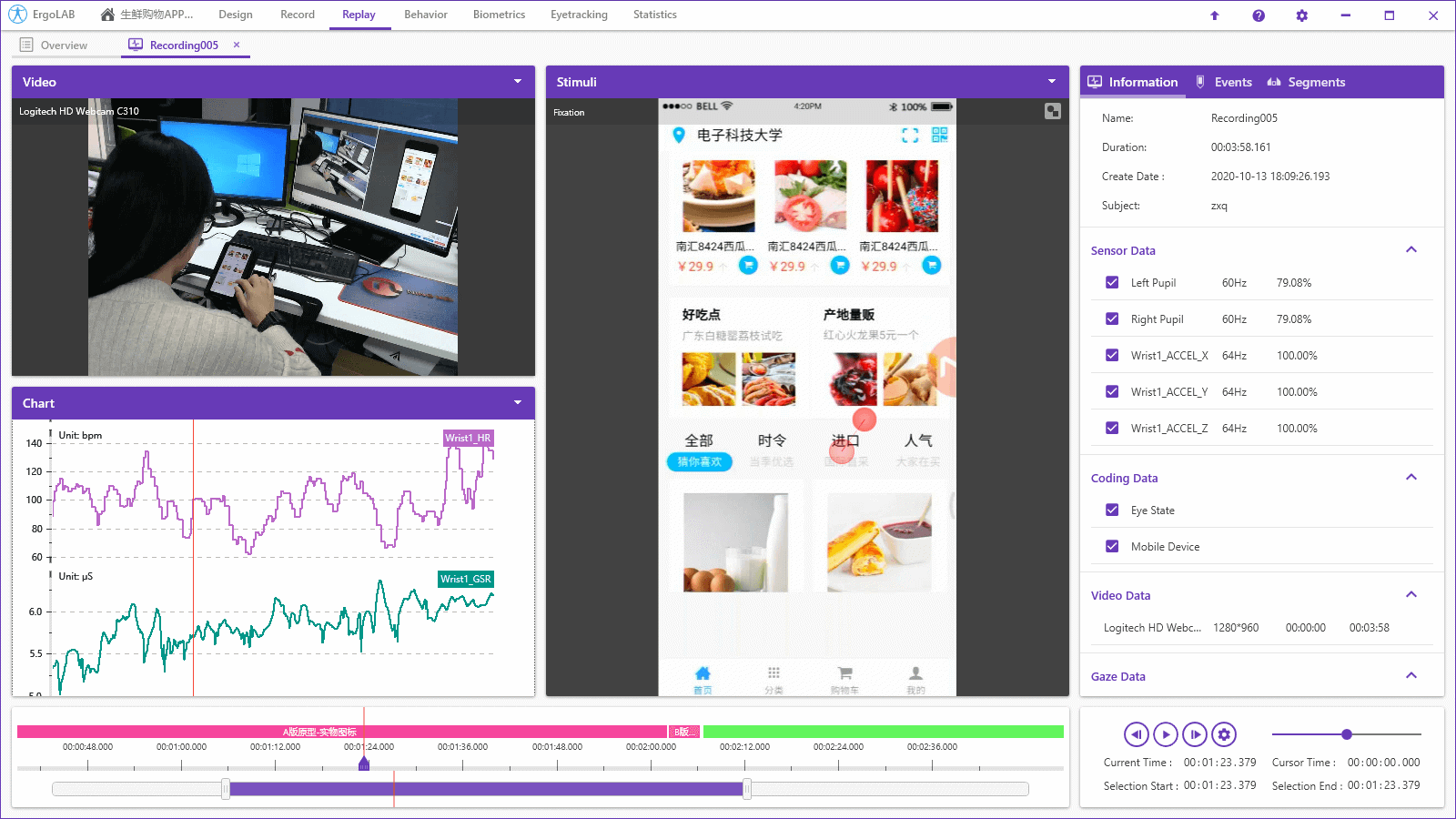

交互行為統計:實時記錄各種刺激材料的交互數據,如頁面瀏覽、跳轉及切換過程中發生的人機交互行為,如鼠標點擊、手指劃過、雙擊等;準確記錄三維沉浸空間的人機交互,包括移動軌跡、抓取物體、按鈕點擊、物體驅動行為等交互數據,以及所有AOI的數據統計。眼動交互分析:支持自動統計所有AOI的眼動數據,統計指標包括進入時間、進入前注視次數、注視時間、總訪問時間、平均訪問時間、訪問次數、總注視時間、平均注視時間、注視次數、平均注視次數、最近鄰近注視點等,以及AOI的可視化序列分析。其他多維度數據同步:基于多維度人機環境時空數據同步技術,可同步采集與分析眼動、生理、行為等多數據源,實現時空分析與交叉統計。支持基于云端的群體實驗與數據疊加分析。ErgoLAB人機環境同步云平臺可人-機-環境多維度數據的同步采集與綜合分析,包括眼動追蹤、生理測量、生物力學、腦電、腦成像、行為、人機交互、動作姿態、面部表情、主觀評 價、時空行為、模擬器、物理環境等,為科學研究及應用提供完整的數據指標。平臺可完成完整的實驗和測評流程,包括項目管理-試驗設計-同步采集-信號處理-數據分析-人工智能應用-可視化報告,支持基于云架構技術的團體測試和大數據云管理。